导语:

随着越来越多的企业认识到数据作为生产要素的价值,加快了企业数字化转型,把完善企业级的数据治理体系作为企业数字化转型的一个目标。长亮科技在大数据领域始终保持足够的技术敏锐度,并积累了丰富的经验与资产。为此,我们组织了一个系列专文,分期发表,与您一起探索更适合当下行业发展的数据观,欢迎大家持续关注。

作者|长亮科技大数据研究院 内容|本篇共3960字,预计阅读时间18分钟

数据是组织的战略资产,组织应该清楚地了解“数据的战略价值”以及如何释放和利用数据来产生积极的业务影响。定义数据战略的起点首先是了解如何以一种经过深思熟虑、可重复、敏捷的方式使用数据来满足企业内外各种需求,从集成主数据开始,部署可重用的高质量数据,最终实现企业级的集成语义层。

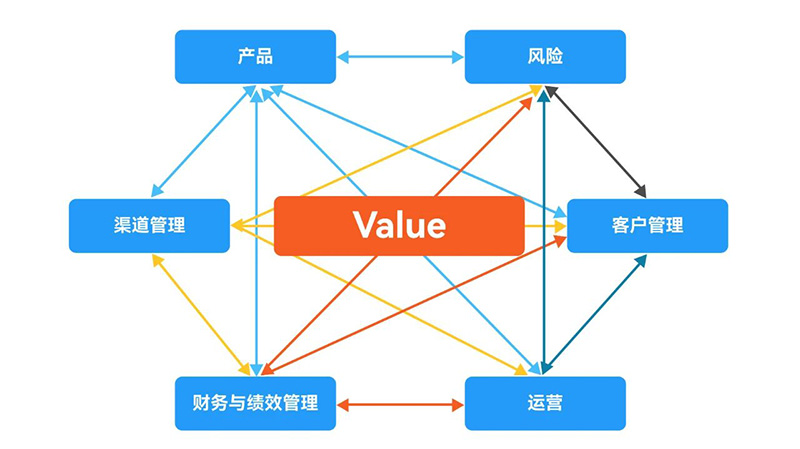

01 需求驱动与业务驱动 许多组织习惯性地将需求驱动软件开发的传统方法应用于数据平台类系统建设中,数据服务部门按照业务部门的需求进行设计、开发提供数据服务。数据服务部门日常穷于应付业务部门用户需求,还要面对需求部门的抱怨,同时承受用户对数据的正确性、一致性以及时效性不满意。由于需求的分析结果不能交互共享,难以在组织内获得并充分利用数据的全部价值,不能消除企业层面的内部障碍。他们日复一日重复开发了数以万计的表,知道自己一直在重复设计和分发相似的可能不正确或冲突的数据,服务于特定目的需求功能,而很少关注数据本身,持续创建孤岛。 基于孤立的、局部的数据,只能产生业务特定的狭隘认知,缺乏支撑业务快速行动所需的黏合力、统一性与敏捷性,很难洞察出更多的业务价值,难以满足业务发展与竞争需要。局部范围的数据质量问题往往也难以及时发现,可能产生不良后果,如误导客户营销,增加风险,导致合规成本飙升等等,投入巨资重复建设而获得的价值很小。 设计良好的软件解决方案可以利用封装的可重用功能组件,获得可靠的质量保证,同时避免了重复开发带来的各种成本与不确定性。 数据价值不在于预定义的处理功能,而在于数据本身。以数据为中心是一种灵活的企业数据架构,在数据分析生态环境中部署可重用的高质量数据:采集最广泛来源的数据,按照统一的规范清洗与转换数据,清理冗余数据,提升数据的准确性、一致性与完整性等内在价值,形成反映企业完整的数据单一视图。然后基于统一的数据创建不同视图重用于多种目的,并确保需要它的每个人都可以访问它,将分析转移到数据中,而不是相反地——为每个需求复制数据。 在数据驱动的背景下,可以有效管理数据需求,新需求首先考虑如何从已搭建的集成数据环境中寻找是否有可重用的数据资产——获得 “免费午餐”,不需要从头开始,因而可以显著降低开发和维护成本,减少寻找数据的时间,快速部署响应市场变化和各种需求。 数据能够回答多少业务问题,取决于数据能产生多少有意义的组合。冗余数据与垃圾数据将使可能的组合发散,有价值的数据被淹没在垃圾海洋中,不能产生更多的有价值的信息,使数据问题扩散,使用户迷惑。数据集市的需求是确定的,因而数据是确定的,所能产生的组合也是确定的。 与分散的数据集市环境存在显著不同,在企业集成数据环境中可以回答的跨领域的业务问题,随着集成数据领域的增加,能回答的问题呈指数级增长,这是回答新问题、产生新价值的来源。 图1:数据能够回答多少业务问题,取决于数据能产生多少有效组合 比尔·恩门认为数据的集成是数据仓库的第一真相。公司越大,这一点就越真实。数据集成是数据仓库建设的核心内容,需要深入调研数据现状,排除垃圾与冗余数据,定义与分类数据,建立数据之间关系。这些工作需要具备专业能力与持久韧性,一些供应商和顾问们忽视甚至排斥集成,但是在数据仓库之外没有其他方法可以进行集成,也没有捷径。 DAMA 等专业组织把数据集成与数据架构分别作为独立的职能。如果把数据集成作为数据架构的一部分,表面上似乎降低了对数据管理相关领域的理解难度与复杂度,但也降低了数据集成的重要性,忽视了数据架构、数据集成、应用架构之间的关系。

02

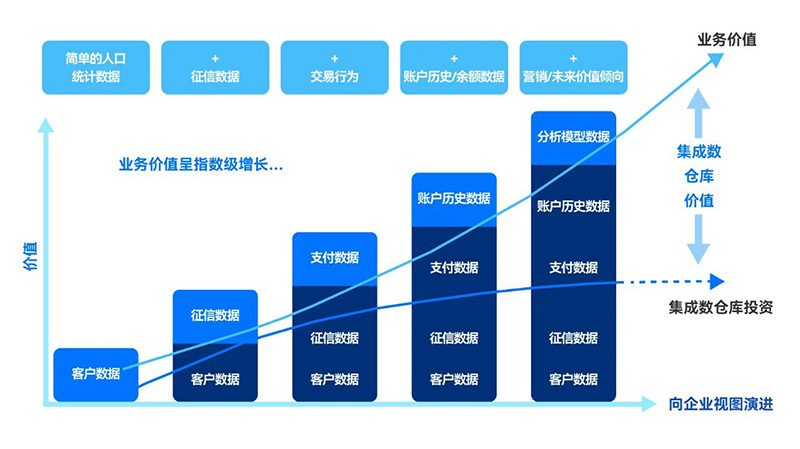

来自于高度的数据集成 彼得·德鲁克说过,效率致力于正确地做事,效果则是做正确的事。 在数据仓库20多年的发展过程中,不同供应商与用户角色专业人员对数据集成的理解与认识存在很大差异,大多停留在表面的粗浅理解中,或故意忽略或回避“数据集成”的本质,既不能正确地做事,也不能做正确的事,数据集成的成熟度没有得到质的提升。 代表高质量数据的完整性来自数据的高度集成。中文语境下的“整合”概念,并不能覆盖英文语境“集成”概念的丰富内涵。英文语境中集成与完整性词根相同,可以说数据集成的本质目标是实现数据的完整性,有清晰的标准要求。把多个数据源以通用格式存储到数据湖中,然后转换为目标物理模型结构的数据,存储在相同的数据模型中,还不是完整的数据集成。 数据集成在逻辑数据建模过程中需要开展以下设计工作: 图2:业务价值随持续集成的数据增长

03

确定集成路线图的初始数据范围很重要,以确保承诺的价值交付时间表。数据部门人员通常会注意到:不同的应用需求,经常需要一些相同的数据,如客户、机构、利率、汇率等主数据以及参考数据几乎被所有应用所需。某些跨职能应用问题具有广泛的业务影响,需要多个主题域来回答,提供前瞻性洞察。应采用务实的策略,尽快满足业务的迫切需求,优先考虑公共需要的数据以及那些直接支持业务目标的已知业务问题并为后续新项目增加附加价值的数据,如风险合规和财务会计以及客户、产品主数据等,杠杆撬动作用大,见效快。 以客户数据为例,客户数据是企业的战略数据,企业价值的实现来自客户。作为关键主数据的客户数据,可能分布在组织内部不同业务系统中,来自不同数据源表达的信息要素各有侧重,客户的结构属性可能有交叉、互补与差异,属性的格式与值有差异,客户记录数也可能有差异,需要集成形成完整一致的集合。不同行业组织之间的客户数据也存在以上这些差异。比如保险业、银行业、电信业关注的信息要素可能有许多不同,包括客户的定义信息、客户购买产品历史、行为偏好等,如何从客户数据中获取价值,都将成为获得竞争优势的关键途径。 通过持续集成来自组织内外不同数据,可以形成客户信息360° 视图,了解产品与服务组合的变化对客户的影响, 更快地识别客户需求、问题、机会,扩大客户群,给不同客户提供不同服务,更有效地向客户交叉销售,提升客户给企业带来的价值。而在应用需求驱动的背景之下,如同盲人摸象,每个人得到的仅是局部片面的信息。 类似还有市场数据、产品数据的集成,特别是市场数据的集成,如基金市场的产品数据,银行既可以代销,也可以使用自有资金投资,本是同一产品概念,在通过不同的渠道接入不同的业务系统时设计了不一致的结构,维护了不同的数据集合,在进行整合时往往不被识别出来而设计成不同的概念,如代销基金产品、共同基金产品。

04 结合最新技术与实践 构建企业集成语义层 需要注意的是,尽管传统的ETL或ELT数据集成流程已经存在了很多年,但数据的集成并不意味着一定伴随数据的移动与复制,可以与数据的位置无关,基于云的数据集成平台越来越普遍。复制需要时间与资源,复制过程可能导致数据泄漏、丢失或变形失真。在许多数据平台与数据应用项目中,不断复制数据,把数据从业务源系统复制到数据湖,再加工复制到数据仓库,从数据仓库迁移到各种集市,野蛮生长之后再进行治理。不同业务系统中的数据价值差异悬殊,一些非核心业务系统中有价值的数据很少,都复制到数据湖中是不明智的。ChatGPT 推动的生成式 AI 兴起,点燃了对高质量数据的需求(质量、时效性与覆盖范围),传统ETL或ELT方法不可能满足这些要求。 结合应用数据架构、分类法、本体模型、业务词汇表、元数据和知识图谱的关键元素,表示组织知识和领域含义,聚合和统一非结构化和结构化数据,定义数据之间的关系,通过持续的数据探索,集成和编目,构建集成的业务语义层,提供来自任何领域的一致信息视图,而无需将所有内容都复制移动到一个系统中。借助集成语义层,可以使用单一框架来访问、理解和集成知识资产,这也是实现人工智能的基础。 2016年 Noel Yuhanna(Forrester)首次提出了大数据编织概念,在Gartner推动下,数据编织已成为现代数据管理的重要趋势。数据编织不强制数据物理迁移,通过主动元数据、知识图谱、人工智能(AI)和机器学习(ML)等技术,动态整合跨平台、跨环境的数据,实现数据的自动化探索、集成、治理和交付。数据编织已从“创新萌芽期”进入“期望膨胀期”,虽没有全面成熟,数据虚拟化、主动元数据管理、AI驱动的数据集成等技术已相对成熟,可用于实现逻辑数据集成和动态编排。 结语: